Motivation

Mobilitätseinschränkungen haben weitreichende Folgen für den Alltag der Betroffenen und führen neben der körperlichen Einschränkung häufig auch zu psychischen Belastungen. Der Rollstuhl stellt oft die einzige Möglichkeit dar, am täglichen Leben teilzunehmen. Klassische Steuerungskonzepte stoßen jedoch bei komplexen Krankheitsbildern (z.B. hohen Querschnittlähmungen) an ihre Grenzen, da die verbleibenden Muskelaktivitäten oft nicht ausreichen, um einen Joystick präzise zu führen.

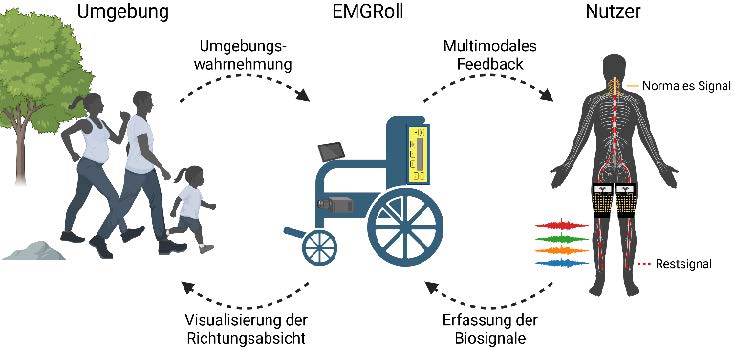

Das Projekt EMGRoll adressiert dieses Problem durch ein Sensor-Kit, das Elektromyographie (EMG) zur Steuerung nutzt. Während klassische Ansätze oft auf starren Regeln basieren, bietet die moderne Robotik mit Methoden des Reinforcement Learning (RL) und Imitation Learning neue Möglichkeiten. Ziel ist es, nicht mehr manuell Regeln für jede Situation zu programmieren, sondern ein multimodales KI-Modell zu trainieren. Dieses soll in der Lage sein, die verrauschten und hoch-individuellen EMG-Signale des Nutzers direkt mit den Umgebungsdaten (z.B. Lidar/Kamera) zu fusionieren. So entsteht eine adaptive “Shared Autonomy”, die die Intention des Nutzers versteht und intelligent in sichere Fahrbefehle umsetzt.

Zielstellung

Ziel dieser Arbeit ist die Konzeption, Implementierung und Evaluation eines Deep-Learning-basierten Navigationsansatzes, der EMG-Signale und Sensordaten in einem gemeinsamen neuronalen Netz verarbeitet.

Die Arbeit beinhaltet folgende Schwerpunkte:

- Recherche: Evaluation des aktuellen Stands der Technik im Bereich Deep Reinforcement Learning (DRL) und Learning from Demonstration (LfD) für assistive Robotik.

- Konzeption: Entwurf einer multimodalen Netzwerkarchitektur, die physiologische Signale (EMG) und exterozeptive Sensordaten (Lidar/Kamera) als Input verarbeitet.

- Implementierung: Entwicklung der Trainingsumgebung (z.B. in Simulationen wie Gazebo, Unity oder Isaac Sim) und Umsetzung des Agenten in ROS2.

- Training & Evaluation: Training des Modells mittels RL oder Imitation Learning und Validierung der Performance im Vergleich zu klassischen Ansätzen.

- Transfer: (Optional/Je nach Umfang) Sim-to-Real Transfer auf den realen Rollstuhl-Demonstrator am FAPS.

Weitere Infos auf Anfrage. Bewerbungen bitte per E-Mail mit aktueller Notenübersicht und Lebenslauf.

References

- Reinforcement Learning Based User-Specific Shared Control Navigation in Crowds

- Learning from demonstration for locally assistive mobility aids

- Learning Shared Control by Demonstration for Personalized Wheelchair Assistance

- Shared control of a brain-actuated intelligent wheelchair

- Shared control methodology based on head positioning and vector fields for people with quadriplegia

Kategorien:

Forschungsbereich:

MedizintechnikArt der Arbeit:

Masterarbeit, ProjektarbeitStudiengang:

Informatik, Maschinenbau, Mechatronik, MedizintechnikTechnologiefeld:

MedizintechnikKontakt:

Matthias Kalenberg, M.Sc.

Department Maschinenbau (MB)

Lehrstuhl für Fertigungsautomatisierung und Produktionssystematik (FAPS, Prof. Franke)

- Telefon: +491622437412

- E-Mail: matthias.kalenberg@faps.fau.de