Beschreibung:

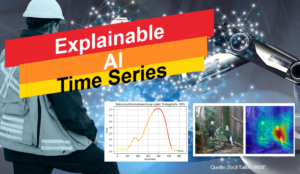

Die faszinierenden Fortschritte im Bereich der Künstlichen Intelligenz (KI) haben zu leistungsfähigen Algorithmen geführt, die komplexe Aufgaben wie Klassifikation und Anomaliedetektion erfolgreich bewältigen können. Jedoch bleiben die Ergebnisse dieser KI-Modelle oft schwer verständlich. Um dieses Hindernis zu überwinden, wurden verschiedene Ansätze entwickelt, um die Entscheidungsfindung von KI-Algorithmen zu visualisieren, darunter Grad-CAM, Heat Maps, Saliency-Maps sowie Surrogate-Models wie LIME. Bisher waren viele dieser Ansätze auf Bildverarbeitung ausgerichtet.

In dieser studentischen Arbeit liegt der Fokus auf der Forschung und Entwicklung von Explainable AI Ansätzen speziell für Zeitreihen. Konkret sollen die genannten Ansätze daraufhin untersucht werden, wie sie auf Prozesskurven von Crimpautomaten angewandt werden können. Das Ziel besteht darin, dass Maschinenbediener die Fähigkeit erlangen, die Entscheidungen der KI bei Fehlerklassifikationen oder Anomaliedetektionen nachvollziehen zu können. Durch die Verbindung von KI und Explainable AI im Kontext von Zeitreihen können zukünftige Anwendungen in der Industrie erheblich von verbessertem Verständnis und Vertrauen in die KI-Entscheidungen profitieren.

Ziel der Arbeit:

Ziel der Arbeit ist die Untersuchung und Anwendung verschiedener Explainable AI Ansätze auf Prozesskurven von Crimpautomaten, um eine verständliche und nachvollziehbare Darstellung der Entscheidungsrundlagen von KI-Modellen für Fehlerklassifikation und Anomaliedetektion zu ermöglichen.

Schwerpunkt und Arbeitsinhalte:

- Systematische Literaturrecherche zum Einsatz von Explainable AI Ansätzen

- Recherche, Gegenüberstellung und Evaluation verfügbarer Ansätze

- Grad-CAM (Gradient-weighted Class Activation Mapping)

- Heat Maps

- Saliency-Maps

- Surrogate-Models (z.B. LIME: Local Interpretable Model-agnostic Explanations)

- SHAP (SHapley Additive exPlanations)

- LRP (Layer-wise Relevance Propagation)

- Feature Importance

- Time Series Decomposition

- Verwendung einer vorhandenen Datenbasis und KI-Modells zur Anwendung der Explainability Ansätze

- Evaluation und kritische Betrachtung der Ergebnisse

- Dokumentation der Arbeit

Was Du mitbringen solltest:

- Interesse an den Themen Künstliche Intelligenz und Explainable AI

- Selbstständige und strukturierte Arbeitsweise, Eigeninitiative und Neugierde

- Programmierkenntnisse in Python von Vorteil, aber nicht zwingend erforderlich

- Vorkenntnisse in Machine Learning von Vorteil, aber nicht zwingend erforderlich

- Sehr gute Deutsch- und/oder Englischkenntnisse

Hinweise und Bewerbung:

- Der Arbeitsumfang und Schwerpunkt der Arbeit können individuell vereinbart werden

- Spezifische Themen können im Anschluss an die Arbeit auch im Rahmen einer Hiwi-Tätigkeit weiterverfolgt werden

- Enge Zusammenarbeit und Austausch mit anderen Studierenden im Bereich KI anhand Gruppenterminen und MS-Teams-Kanal

- Teilweise Zusammenarbeit mit Industriepartnern aus der Bordnetzbranche möglich

Schicke mir bei Interesse bitte eine E-Mail mit Lebenslauf und aktuellem Notenspiegel an bernd.hofmann@faps.fau.de

Kategorien:

Forschungsbereich:

Signal- und LeistungsvernetzungArt der Arbeit:

Bachelorarbeit, Masterarbeit, ProjektarbeitStudiengang:

Energietechnik, Informatik, IPEM, Maschinenbau, Mechatronik, WirtschaftsingenieurwesenKontakt:

Bernd Hofmann, M.Sc.

Department Maschinenbau (MB)

Lehrstuhl für Fertigungsautomatisierung und Produktionssystematik (FAPS, Prof. Franke)

- Telefon: +491622355258

- E-Mail: bernd.hofmann@faps.fau.de